Deepfake, ¿cómo enfrentar la amenaza?

Por: Agencia Informativa UDEM

Taylor Swift es uno de los últimos capítulos en la historia de los deepfakes o imágenes falsas que son creadas con inteligencia artificial para dañar la reputación o credibilidad de las personas y que inundan las redes sociales despertando el morbo de millones de usuarios, al tiempo que causan un daño irreparable para quien es expuesto mediáticamente.

El deepfake es una imagen, un video o un audio falso o engañoso que parece real. Son hechos con tecnología y se basan en material real, el cual es alterado para simular que una persona es lo que no es o hace lo que realmente no hace.

La mayoría de los deepfakes tienen que ver con material sexual explícito que se usa para distintos fines, desde los comerciales hasta los de extorsión, venganza, acoso y bullying. Prácticamente todas las personas son potenciales víctimas, aunque actualmente son las mujeres las que se han visto más afectadas.

Esta capacidad para manipular imágenes implica, por ejemplo, tomar una fotografía real y usar sólo el rostro de la persona para ponerlo en el cuerpo de otra o en un cuerpo falso. La inteligencia artificial hace que esta fusión o superposición de imágenes sea casi perfecta, al punto que cualquier persona puede verla como real y no dudar de su autenticidad. Igual puede pasar con los videos y con los audios, que son generados por algoritmos de deep learning, o aprendizaje profundo, que garantizan una exactitud casi total con el original.

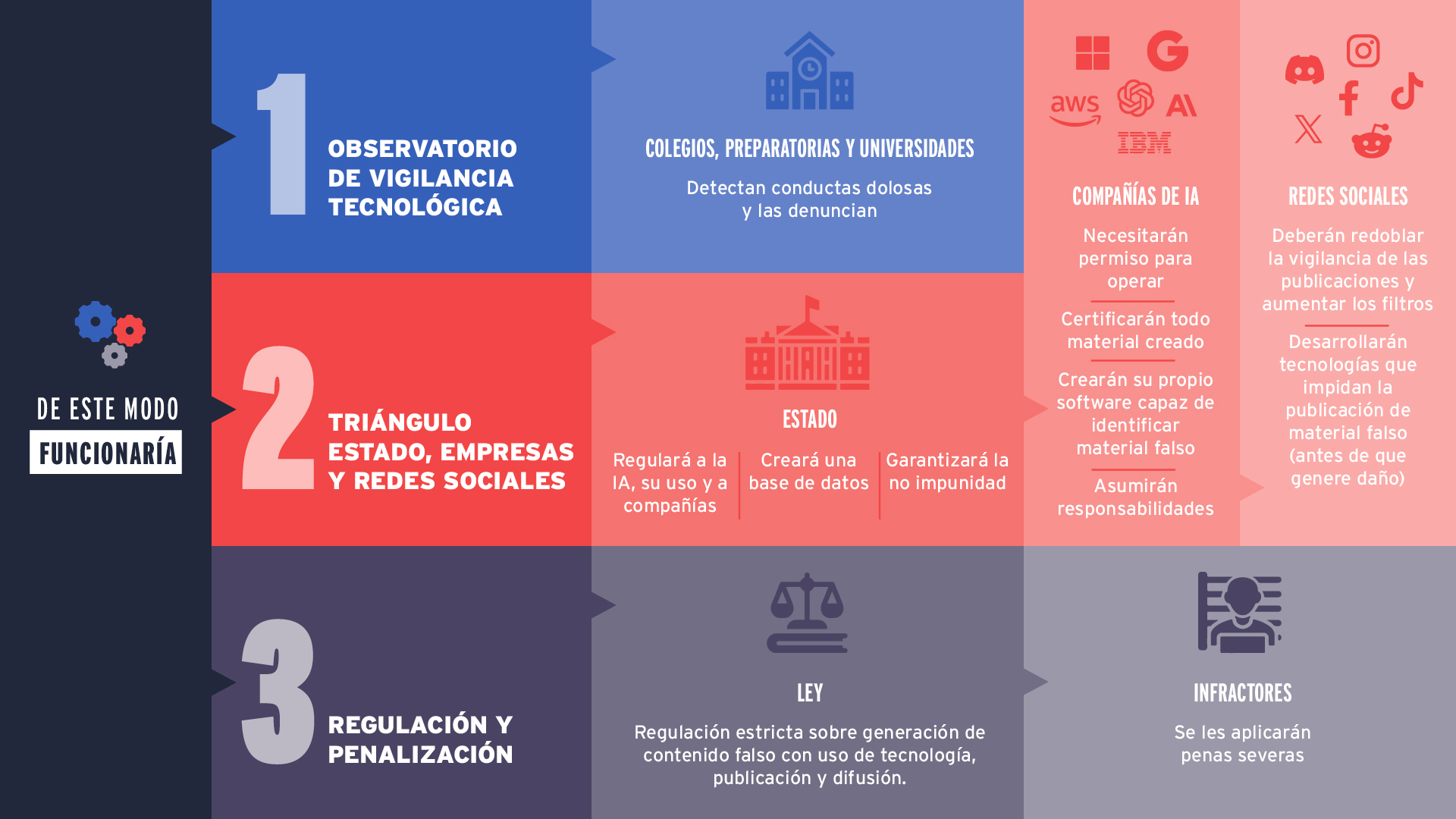

El impacto del uso de estas tecnologías en la vida de las personas exige una regulación urgente que las proteja contra el uso indebido de sus datos personales, la manipulación de su imagen, la violación de sus derechos y el daño a su persona.

Lo que comenzó siendo una herramienta usada en el cine para solucionar problemas de producción, edición de escenas o una estrategia creativa de los diseñadores gráficos o una experimentación de programadores, se ha convertido en una tecnología, hoy al alcance de muchos, que amenaza con vulnerar derechos fundamentales y afectar la salud física y mental de millones de personas, principalmente adolescentes.

«Hoy vivimos en una sociedad de redes, interconectada, que nos facilita la comunicación y el conocimiento, pero la tecnología también tiene un lado oscuro que debemos evitar, protegernos de él y regular. El deepfake es ese lado oscuro de la tecnología», afirma Myrna Elia García Barrera, profesora de las facultades de Derecho de la Universidad de Monterrey (UDEM) y de la Universidad Autónoma de Nuevo León (UANL), al referirse al mal uso que se le da a la tecnología para violentar a las personas, especialmente a las mujeres y a las niñas, a través de actos conocidos como «violencia digital».

Beatriz Elena Inzunza Acedo, doctora en Estudios Humanísticos, asegura que el impacto del uso de estas tecnologías en la vida de las personas exige una regulación urgente que las proteja contra el uso indebido de sus datos personales, la manipulación de su imagen, la violación de sus derechos y el daño a su persona.

Ni Taylor Swift se salva

El jueves 25 de enero, las redes sociales, especialmente X, se inundaron de imágenes sexuales de la cantante estadounidense Taylor Swift generadas con inteligencia artificial que se hicieron virales en minutos. Aunque sólo circularon ese día en estas plataformas, las fotografías falsas alcanzaron solamente en una cuenta 47 millones de vistas, se volvieron a publicar unas 24 mil veces y recibieron cientos de miles de «me gusta» antes de que se suspendiera o eliminara la cuenta por violar las políticas de la plataforma.

Las imágenes falsas de la cantante fueron retiradas de las redes sociales, pero los fans de Swift cuestionaron la falta de seguridad de estas plataformas, la nula prevención y la falta de rapidez para limpiar las redes de material dañino para la imagen de la cantante, al tiempo que reclamaron la falta de leyes que castiguen estos delitos.

El ataque a Taylor Swift es sólo uno entre muchos. Otras celebridades también han sido víctimas de los deepfakes sexuales explícitos, como Meghan Markle, Megan Fox, Kate Upton y Rosalía.

Sin embargo, «miles de mujeres y niñas alrededor del mundo pasan por lo mismo y sus casos no se conocen. Estos ataques contra las mujeres profundizan aún más la violencia de género y las dejan más vulnerables ante la sociedad», afirma Paola Josefina González Castro, profesora de la Escuela de Psicología de la UDEM.

«Miles de mujeres y niñas alrededor del mundo pasan por lo mismo y sus casos no se conocen. Estos ataques contra las mujeres profundizan aún más la violencia de género y las dejan más vulnerables ante la sociedad».

«El deepfake es violencia ejercida sobre una mujer de manera consciente, en donde ella es vista como un objeto en un acto de superioridad de quien ejerce esa violencia y esto es un tipo de abuso sexual», sostiene.

Para Beatriz Elena Inzunza, también profesora del Departamento de Cine y Comunicación, en la Facultad de Educación y Humanidades de la UDEM, «estos casos de desinformación, manipulación de imágenes y tecnologías que se usan para falsear contenidos ponen en peligro, incluso, la vida de las mujeres y, justo ahora que estamos en un tiempo donde valoramos más la salud mental y emocional, tendríamos que estar considerando que esto tiene un fuerte impacto y ante la posibilidad de que se cause un daño, ya debería haber una regulación de por medio».

Caso Politécnico y la regulación

En México, el primer caso público de uso de herramientas de inteligencia artificial para crear contenido sexual falso se hizo público en octubre de 2023.

Diego «N», un estudiante de Mercadotecnia Digital del Instituto Politécnico Nacional (IPN), tomó de redes sociales más de 50 mil fotografías de alumnas de ese Instituto, las modificó sin su consentimiento y generó con ellas más de 160 mil imágenes íntimas con inteligencia artificial, las cuales comercializó y vendió como contenido íntimo. Las alumnas afectadas lo denunciaron, la institución lo expulsó por violencia digital y fue detenido el 26 de octubre por la Fiscalía General de Justicia de la Ciudad de México acusado de, presuntamente, haber cometido el delito contra la intimidad.

El 22 de noviembre de 2023, la diputada María Guadalupe Morales Rubio, de Morena, presentó una iniciativa ante el Congreso de la Ciudad de México que busca endurecer las penas de prisión a quienes hagan uso de la tecnología para generar contenido sexual falso de personas reales.

La violencia digital y los delitos que violen la intimidad sexual de las personas a través de medios digitales, también conocida como ciberviolencia, fue reconocida y penalizada en México en el año 2018 a través de un conjunto de reformas, conocidas como la Ley Olimpia. Esta Ley castiga el acoso digital y tipifica como delito contra la intimidad sexual grabar, tomar fotos o difundir imágenes o mensajes de contenido sexual sin consentimiento de la otra persona, pero no se refiere específicamente a la manipulación de imágenes o videos mediante el uso de la inteligencia artificial.

La Ley Olimpia se aprobó primero en el estado de Puebla, el 10 de diciembre de 2018, y luego en las demás entidades federativas del país. En abril de 2021, el Congreso de la República aprobó las reformas a nivel nacional y fijó una condena de tres a seis años de prisión para quien cometa las mencionadas conductas. La iniciativa presentada por la diputada Morales busca elevar las penas a entre ocho y 12 años de prisión a quien utilice la inteligencia artificial para crear contenido íntimo falso.

Deepfakes amplían la brecha de género

En un mundo en donde aún se lucha por alcanzar la igualdad de género, el auge de las tecnologías, la mala utilización de ellas y la falta de regulación ponen a la mujer en una situación de mayor vulnerabilidad y más susceptible de sufrir actos de violencia, afirma Myrna Elia García Barrera, autora del libro Género, Derecho y Tecnología, en el que analiza estas problemáticas que afectan la integridad de las mujeres y expone soluciones legales y culturales que se tendrían que implementar.

«Una amplia protección de los derechos de la mujer implica una legislación más completa y más fuerte, pero también tiene que presentarse un cambio cultural importante con respecto a la igualdad de género. Tenemos que empezar a educar a iguales y a dejar de pensar en la mujer como cosificación, como sujeto sexualizado, y esto tenemos que trabajarlo desde el hogar y la academia», indica la jurista.

Las empresas de inteligencia artificial «tienen que hacer más para proteger a los usuarios».

Simultáneamente, agrega, los legisladores deben trabajar en tipificar todos los delitos contra la mujer atados al mal uso de la tecnología, especificando claramente a quién se le van a atribuir los efectos jurídicos de un hecho realizado mediante el uso de la inteligencia artificial o la tecnología y en el que, a primera vista, no hay un responsable directo. Esto para poder castigar penalmente a quienes violenten a las mujeres con la creación y difusión de contenido sexual falso.

Una ley en esta materia debe contemplar la responsabilidad que le cabe a las empresas de inteligencia artificial, por cuanto estas «tienen que hacer más para proteger a los usuarios. Ellas deben frenar la mala utilización que se hace de sus plataformas y herramientas tecnológicas y entregarle a las autoridades las pruebas o datos de quién o desde dónde se crea material falso para difamar a las personas», dice la experta.

«Son varios los derechos humanos básicos que se están violentando por el mal uso de la tecnología. El derecho al buen nombre, a la dignidad, a la intimidad, el derecho a la propia imagen y los derechos a la interconexión y al resguardo de los datos personales. Todos deben estar protegidos por la Ley», afirma García Barrera.

Solo la Ley no basta

Aunque los especialistas aplauden un endurecimiento de la ley para avanzar en la protección de derechos, creen que por sí misma es insuficiente para resolver el problema y garantizar ambientes digitales más seguros.

Los deepfakes se han extendido más allá del ámbito sexual y actualmente ya no se usan sólo para atacar a las mujeres o para lucrarse con sus imágenes.

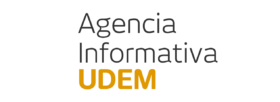

Umberto León Domínguez, experto en Inteligencia Artificial y profesor de Neuropsicología y Conducta Digital en la UDEM, propone una solución integral desde tres frentes. El primero, conformado por la sociedad civil, sería preventivo y de denuncia.

«Necesitamos crear un observatorio de vigilancia tecnológica o de vigilancia del uso de la inteligencia artificial. Funcionaría en colegios, preparatorias y universidades. Si allí se detectaran conductas que pudieran llegar a afectar a las alumnas, se tendría que denunciar inmediatamente ante un organismo interno y a nivel estatal», explica León Domínguez.

Sin embargo, los deepfakes se han extendido más allá del ámbito sexual y actualmente ya no se usan sólo para atacar a las mujeres o para lucrarse con sus imágenes, por lo que el experto afirma que se requiere un segundo frente de acción, al que define como «Triangulación Estado – compañía de IA – redes sociales».

«La relación y el trabajo coordinado entre estos tres actores marcarán la diferencia porque se regulará, las compañías asumirán su responsabilidad y juntos podrán detener rápidamente el daño que se pueda infringir contra una persona», dice el experto.

Según su propuesta, el Estado, además de legislar el tema y establecer penas severas contra los infractores, crearía un padrón o base de datos que incluya el nombre de todas las compañías de inteligencia artificial que tengan presencia en el país, las cuales no podrían operar si no tienen un permiso previo del Estado y su consecuente registro.

Al mismo tiempo, obligaría a estas empresas a certificar cada imagen que sea creada a través de sus sistemas etiquetándola con un sello o marca de agua que no pueda ser borrada, lo cual ayudaría a identificar el material falso. Además, propone que se obligue a estas empresas a crear su propio software capaz de detectar videos o imágenes falsas para que cualquier persona pueda hacer una verificación rápida y contribuya a poner la alerta.

Tal relación funcionaría así: Cada imagen o video que sea subido a la red debe pasar por un filtro obligatorio de las empresas de IA generativa que detecte si el material es real o falso y si realmente fue generado a través de sus sistemas con la verificación de la marca de agua.

«Si es falso, se debe actuar rápidamente para frenar el daño. En minutos, la empresa de IA debe certificar la autenticidad y publicar en sus redes sociales que es falso, además de informarle a las redes sociales que retiren inmediatamente el material de sus plataformas. Mientras que sitios como X, Instagram o Facebook, deberán tomar una mayor responsabilidad frente a lo que los usuarios publican y redoblar la vigilancia sobre las publicaciones para eliminarlas en el menor tiempo posible si éstas son falsas», explica León Domínguez.

Ya hay compañías de inteligencia artificial que lo hacen, aclara el experto, pero fallan los controles porque se siguen creando «deepfakes erótico sexuales».

«Los chatbots (software inteligente o apps informáticas basadas en IA) de imágenes disponibles suelen tener restricciones para hacer ciertos tipos de imágenes. Por ejemplo, en DALL-E 3, el generador de imágenes de OpenAI, no se puede pedir nada sexual, pero, de alguna forma, hay quienes logran saltarse el algoritmo que lo impide, bien porque usan un algoritmo que no es famoso y que no tiene estas limitantes o porque logran saltarse las restricciones de los algoritmos generativos de imágenes más famosos», indica.

Estas maneras que se ingenian para seguir cometiendo el delito es lo que lleva al tercer frente de acción propuesto por León Domínguez: una legislación que establezca penas fuertes para quienes hagan, publiquen o difundan deepfakes o noticias falsas que atenten contra la dignidad, el buen nombre y la reputación de una persona «porque esto desencadena una serie de consecuencias que pueden acabar con la carrera profesional de una persona o, incluso, llevarla al suicidio».

Model Emily Pellegrini, amassing 137,000 followers in 4 months, is a digital creation. Formed by neural networks as the 'average man's dream girl,' she's a virtual Instagram hit, earning $10,000 and attracting billionaire suitors, highlighting the era of digital illusion. ????????… pic.twitter.com/0bpbFJ8EE7

— Tansu Yegen (@TansuYegen) January 7, 2024

IA crea un nuevo concepto de belleza

La manipulación tecnológica a través del uso de la inteligencia artificial ha llegado al punto de crear nuevos modelos de belleza que amenazan con influir en las nuevas generaciones.

Umberto León Domínguez advierte sobre el denominado «hotness hyperinflation«, un fenómeno que está ocurriendo en la web y en el que modelos e influencers hipersexualizadas generadas por inteligencia artificial están introduciendo un nuevo concepto de belleza que cada vez acumula más seguidores.

Este post muestra a una chica que no existe en la vida real. La modelo Emily Pellegrini, que acumula 137 mil seguidores en cuatro meses, fue generada por inteligencia artificial. «Formada por redes neuronales como la ‘chica soñada del hombre promedio’, es un éxito virtual en Instagram. Gana 10 mil dólares y atrae pretendientes multimillonarios, destacando la era de la ilusión digital», se lee en el post.

«La inteligencia artificial y su capacidad generativa de la sexualidad de la mujer es un peligro para las nuevas juventudes y su salud mental», afirma León Domínguez.

Meta da primeros pasos en seguridad

Después del escándalo generado por las imágenes falsas de Taylor Swift, la compañía estadounidense Meta anunció, el 6 de febrero, que avanza en el desarrollo de una herramienta que le permitirá a sus redes sociales (Facebook, Instagram y Threads) identificar las imágenes generadas por inteligencia artificial.

El pronunciamiento de la empresa también se da después de que Mark Zuckerberg, director general de Meta, y directivos de otras redes sociales enfrentaran el 31 de enero pasado los cuestionamientos de los congresistas que integran la Comisión de Asuntos Jurídicos del Senado de Estados Unidos y a padres de familia que les reclamaban por su responsabilidad en el daño que las redes sociales causan en niños y adolescentes.

Legisladores y padres culpan a estas empresas de alentar y propagar contenidos dañinos para las jóvenes como la creación de estándares de belleza poco realistas, provocar acoso, trastornos alimenticios y hasta suicidios, generar adicciones, permitir la presencia de depredadores sexuales en las redes y desencadenar problemas psicológicos y mentales, sin preocuparse por estos efectos ni hacer lo suficiente por la seguridad y la vida de los jóvenes.

«Son responsables de muchos de los peligros que nuestros niños enfrentan en línea (…). Sus elecciones de diseño, el no invertir adecuadamente en confianza y seguridad, su constante búsqueda de interacciones y el situar a las ganancias por encima de la seguridad básica han puesto a nuestros hijos y nietos en riesgo», dijo el senador Dick Durbin, presidente de la Comisión.

Nick Clegg, responsable de asuntos internacionales de la empresa, explicó el 6 de febrero en un blog que desde diciembre la compañía ya identifica las imágenes que son generadas con su propia herramienta, Meta IA, pero ahora «queremos poder hacer lo mismo con contenidos creados con herramientas de otras empresas» como Google, OpenAI, Microsoft, Adobe, Midjourney o Shutterstock, dijo Clegg.

La herramienta, que está en desarrollo, será lanzada en los próximos meses «y comenzaremos a aplicar etiquetas en todos los idiomas compatibles con cada aplicación», señaló el directivo.

Sin embargo, Clegg advirtió que este sistema no garantiza que se elimine totalmente el riesgo de generar imágenes falsas, pero aseguró que minimizará la producción y publicación de las mismas.

«No es perfecto, la tecnología aún no está completamente desarrollada, pero de todas las plataformas es el intento más avanzado hasta ahora para proporcionar transparencia de forma significativa a miles de millones de personas en todo el mundo», dijo Clegg a medios internacionales.

Con el objetivo de motivar la participación ciudadana y para garantizar un tratamiento informativo adecuado frente a los contenidos presentados, los invitamos a escribir a [email protected] en caso de dudas, aclaraciones, rectificaciones o comentarios.